گوگل کد اخلاق جدیدی را برای هدایت رویکرد خود نسبت به هوش مصنوعی که شامل ممنوعیت استفاده سلاح مبتنی بر هوش مصنوعی ایجاد کرده است.

این اعلامیه پس از اعتراض شدید کارمندان گوگل به شرکت در پروژه Maven منتشر شده است. این یک پروژه مشترک است که ارتش آمریکا قصد دارد از فناوری هوش مصنوعی گوگل برای ایجاد یک الگوریتم جنگی بین عملیاتی استفاده کند.

خبر این همکاری باعث ترس از این موضوع شده است که چگونه فناوری میتواند در آینده به خودکارشدن جنگ کمک کند. بنابراین، پس از مواجه شدن با فشار از کارکنان و سایر افراد در مورد این قرارداد، گوگل در نهایت اعلام کرد که قراردادش را تمدید نخواهد کرد.

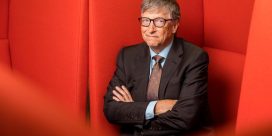

ساندار پیچای، مدیرعامل گوگل در پستی اعلام کرد که مجموعهای از هفت اصل جدید را برای هدایت استفاده از هوش مصنوعی گوگل بوجود آمده است. اصول هدایت کننده این است که برای استفاده از هوش مصنوعی گوگل باید:

- برای جامعه سودآور یاشد

- از خطای الگوریتمی اجتناب شود

- ایمنی، آزمایش شده باشد

- پاسخگو به عموم باشد

- بر حریم خصوصی متمرکز باشد

- حفظ تعالی علمی در نظر گرفته شود

- به اهدافی که با این اصول هماهنگ شدهاند، در دسترس باشد

وی همچنین اشاره کرد که حتی اگر این شرکت از هوش مصنوعی برای ایجاد سلاح استفاده نکند، همچنان با دولت و ارتش در سایر زمینه ها مانند امنیت، آموزش و جستجو و نجات همکاری میکند.

پیچای همچنین خاطرنشان کرد که گوگل از ایجاد یک تکنولوژی نظارتی که هنجارهای حقوق بشر پذیرفته شده بین المللی را نقض کند یا چیزی که قوانین بین المللی را زیر پا بگذارد، جلوگیری خواهد کرد.

هوش مصنوعی در حال راه یافتن به تمام ابعاد زندگی افراد است و استفاده نظامی از هوش مصنوعی که شرکت ها سعی می کنند هر چه بشتر آن را بفروش برسانند، یک راز نیست. اما به نظر می رسد باوجود آنکه گوگل به شعار “شر نباش” پشت کرده است، همچنان به حفظ فرهنگ آرمانی خود ادامه می دهد.

نظرات